Heh, titlu clickbait! De fapt, văd că în 2022 au fost adoptate oficial în Sistemul Internațional prefixele Ronna și Quetta. Un ronna, prescurtat R, înseamnă 10 la puterea 27, adică 1.000.000.000.000.000.000.000.000.000, care este ceva de genul 1 miliard de miliarde de miliarde.

Am făcut un calcul funny. Am vrut să exprim distanța până la Soare în ronnametri. Boy, was I naive! Se pare că dacă pui cap la cap un milion de galaxii cât a noastră iese o distanță de un ronnametru (cred). Așa că nu am găsit o comparație ușor de făcut.

Și mai există quetta, care este 100o de ronna.

Anyway, am avut senzația asta că ne trebuie noi multipli sau măcar să-i înțelegem mai ușor pe cei existenți atunci când am urmărit prezentarea lui Jensen Huang, CEO-ul NVIDIA, de la recenta conferință GTC a companiei.

Ca să devin serios acum, mi se pare că lumea computingului și în special ce face NVIDIA se apropie de magie. Se apropie de valori, de viteze de procesare care pur și simplu nu mai sunt ușor de înțeles nici măcar de o persoană informată. Și apoi te gândești că cineva proiectează toate acestea, că le face să lucreze sincronizat, fără erori, și nu pot decât să mă gândesc cum? cum fac asta? ce creier au oamenii aceia? ce viziune trebuie să aibă asupra întregului sistem?

Dar na, știți cum a zis Clarke: o tehnologie suficient de avansată nu poate fi deosebită de magie.

Ca un scurt preambul, v-ați gândit că într-un procesor de 3 GHz, ceva uzual astăzi, înseamnă că au deci loc 3 miliarde de operațiuni în fiecare secundă? În pătratul acela mic, de câțiva centimetri pe fiecare latură, un ceas face tic-toc de 3 miliarde de ori pe secundă.

Și, întrucât avem și paralelism acolo, de 3 miliarde de ori pe secundă niște instrucțiuni sunt citite, altele sunt executate, se trimit interogări către memorie, se scriu date în cache șamd.

Imaginați-vă o fabrică, ceva cu bandă de producție. Poate că produce biscuiți sau produce autoturisme. Imaginați-vă că banda avansează de 3 miliarde de ori în fiecare secundă și tot de atâtea ori se fac operațiuni pe ea.

Începe conferința. Urmăriți mai sus cum Huang aruncă într-un stil foarte casual cu cifre și urmăriți ce multipli folosește. De exemplu, zice că este dificil să antrenezi un AI mai complex pentru că va crește foarte mult numărul de token-uri ce trebuie generate.

Zice că cel mai complex AI în acest moment are cam 1,8 mii de miliarde de parametri. Adică 1,8 tera-parametri sau 1.800 de giga-parametri, așa cum vorbim de gigaytes și terabytes în mod uzual. Și că pentru acel model se procesează și miliarde de token-uri.

Chiar și un GPU de 1 petaFLOPS ar avea probleme cu asta. Peta = 1000 de tera. FLOPS înseamnă floating point operations per second, niște operațiuni matematice pe secundă. PetaFLOPS înseamnă un milion de miliarde de operațiuni pe secundă.

Unui GPU de 1 PetaFLOPS i-ar lua 30 de miliarde de secunde să antreneze acel model. Cam 1000 de ani înseamnă asta, zice Huang pe scenă.

Nu poți aștepta atât, așa că ai nevoie de GPU-uri mai puternice și de super-computere care folosesc simultan sute de astfel de plăci video pentru calcule.

Așa că introduce cip-ul Blackwell, care este baza noii tehnologii de procesare AI de la NVIDIA. Cipurile Hopper, pe care NVIDIA nu le poate produce suficient de repede pe măsura cererii, sunt deja “generația anterioară”.

Un cip Blackwell are 104 miliarde de tranzistoare în interior și este produs în 4 nm. NVIDIA le unește câte două astfel de cipuri și le spune “unitate Blackwell”. 208 miliarde de tranzistoare și o bandă de transfer între cele două jumătăți de 10 TB/s, viteză la care, zice Huang, dispar limitările aduse de faptul că memoria este externă. O jumătate de Blackwell poate accesa memoria integrată în cealaltă jumătate cu așa o viteză de mare încât pare că este memoria ei.

NVIDIA combină apoi două unități Blackwell și un cip Grace (o generație mai veche) într-un pachet numit GB200. Îi adaugă un bridge NVLink îmbunătățit și un engine care verifică periodic de erori și defecțiuni la nivel de unitate, pentru a micșora downtime-ul.

Rezultatul este o îmbunătățire de 5 ori peste Hopper, ajungând la 40 de petaFlops procesare și la transferuri de 34 de tera-parametri pe secundă cu memoria.

Poți pune mai multe astfel de unități într-un server, apoi mai multe servere într-un rack. Poți construi un data center cu mai multe rack-uri de acest tip.

Rezultatul? Un data-center cu 32.000 de cipuri Blackwell poate atinge o viteză de procesare de 645 exaFlops, cu o memorie totală de 13 PB, o bandă totală de 58 PB/s și in-network computing de 16,4 petaFlops.

1 exa înseamnă 10 la puterea 18, adică o mie de peta sau un milion de tera.

Și aruncă pe acolo în prezentare cu peta și exa de parcă ar fi nimic, de parcă ar fi la ordinea zilei. Îmi aduc aminte că am citit cândva că se deschide primul super-computer din lume de 1 exaFlops. Poți avea acum 645 de exaFlops cu câteva rack-uri.

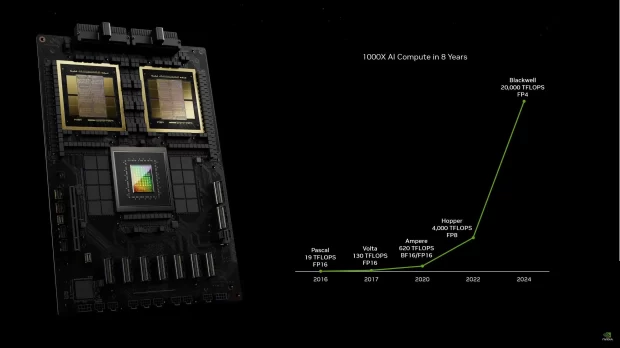

Mai spune Huang că puterea de procesare a plăcilor NVIDIA a avansat de 1000 de ori în 8 ani. Pascal, în 2016, avea 19 teraFlops. Hopper, în 2022, avea 4000 de teraFlops. Blackwell se duce la 20.000 de teraFlops.

Legea lui Moore estimează o creștere de performanță de 100 de ori la fiecare 10 ani. NVIDIA a obținut 1000 de ori în 8 ani. Văd ei ce vor anunța peste doi ani și care va fi raportul final.

Huang glumește apoi un pic spunând că-și aduce aminte cum a livrat el primul accelerator AI către OpenAI, acum niște ani. Acela avea o putere de procesare de 0,2 petaFlops. L-au semnat cu toții și s-au bucurat.

Acum, un rack cu Blackwell are 720 de petaFlops.

Revine apoi la exemplul său cu modelul AI cu 1,8 mii de miliarde de parametri care ar dura 1000 de ani pentru a fi antrenat de un singur GPU.

Un sistem bazat pe Hopper poate face asta în 90 de zile, folosind 8000 de plăci video și consumând 15 megawați putere.

Un sistem bazat pe Blackwell poate face asta în 90 de zile, dar folosind doar 2000 de plăci video și consumând doar 4 megawați.

De 4 ori mai rapid. Sau de 4 ori mai economic, depinde ce preferi.

Prezentarea continuă cu o listă lungă de parteneri care folosesc sisteme NVIDIA. Microsoft, Google, IBM, Oracle, Dell, toți care construiesc AI-uri o fac pe sisteme NVIDIA. Zice apoi despre cum în viitor nu vei mai scrie cod, ci îi vei spune unui AI ce vrei să facă acel cod, iar AI-ul îl va genera pentru tine. Sistemele generative funcționează tot mai bine și mai precis, iar cele multi-modale sunt tot mai bune.

Vorbește despre platforma lor de proiectare Omniverse și cum poți da de două ori mai repede drumul la o fabrică sau linie de producție când o proiectezi în Omniverse. Super-computerele pot prezice vremea cu o rezoluție crescută de la 25 km la 2 km. Drive Thor este un computer performant pentru vehicule moderne. La final apar și roboți pe scenă, Star Wars style, se mișcă pe acolo, fac cu mâna, chiar zici că sunt din film.

Mie mi-a rămas însă mintea la ușurința cu care se aruncă în discuție exaFlops și teraParametri. Uimitor cât de variată este lumea asta. Unii oameni pot să dezvolte așa ceva și să rezolve probleme de scalare pe care nici nu mi le pot imagina. Alții cred că Pământul este plat sau că buletinele îi vor spiona.

Alte treburi: David Blackwell a fost un matematician american. Acțiunile NVIDIA erau acum un an pe la 250 USD și analiștii au crescut periodic ținta de preț spre 600 USD, apoi 900 USD, iar zilele acestea spre 1.100 USD.

M-am uitat pe cel mai recent raport financiar al companiei. Anul trecut, NVIDIA a avut venituri de 60 de miliarde de dolari. Divizia de gaming a adunat 10 miliarde de dolari, în creștere cu 15%. Divizia de centre de date/AI a adunat 47,5 miliarde de dolari, în creștere cu 217%.

Această știre este preluată prin Roboțelul iDOR.info!

Sursa acestei stiri: Avem nevoie de multipli mai mari în sistemul de măsură, inspiră NVIDIA

Autor/editor:

Redacția: Redacția @ Stiri Google